在治理内容社区、维护内容安全的平台运营过程中,运营人员往往需要保证内容质量,避免违规内容的出现,以保障用户的使用或阅读体验。那么,常见的内容安全问题和质量问题有哪些?我们又应该如何做好治理动作?一起来看看作者的经验分享。

写这篇文章最害怕的就是涉及公司机密信息,反复检查了好几遍所举案例。

写这篇文章的目的,首先,这并不会涉及到公司机密。其次,我们治理过的这些问题大部分属于内容行业共存的问题,但对于不同公司的风控人人员不一定能够关注全面。

所以打算脱敏写出来,风控人员可以查漏补缺,希望能够对内容行业产生一点帮助,共同使行业更好。

在工作中,我负责公司社区生态治理,主要包括干掉坏内容、干掉坏用户、提升内容质量、提升用户体验。这篇主要说干掉了哪些坏内容、干掉了哪些坏用户。

本文从以下几个方面展开来说:

- 治理内容安全问题;

- 治理内容质量问题;

- 从用户角度做治理;

- 处罚方式;

- 治理经验。

一、治理内容安全问题

干掉坏内容包括两部分,一部分是业务型内容,即业务不需要的这部分内容,一部分是安全型内容,即监管部门让删除的内容。

治理过的安全内容很多,例如涉黄、危害青少年、引导错误的价值观、负面舆情等,这些是监管部门明确要求不能存在的(这几个好举例,其他治理过的涉及安全的内容不一定适合举例)。

二、治理内容质量问题

对于质量型内容,监管部门不会来要求删除,但平台不希望这类型内容存在,例如有用户 5 月份在多条帖子下大量评论“新年快乐”,这个对业务来说,属于低质评论,需要治理的对象,下面将展开说我们主要治理过的问题。

1. 重复 / 改写 / 抄袭

由于生产有奖励,用户生产有成本,所以部分用户有动机将已经生产的优质内容复制,然后重新发布以便快速获得奖励。

为避免内容同质化,及平台花钱买到低质内容,所以会治理这类型内容。

从内容形式上划分可划分为重复图片、重复文本(也有重复视频,但治理方式识别方式类似重复图片,所以未单独划分)。

1)重复图片

需要治理重复图片是因为用户消费一段图文内容时,会优先看到图片,若图片相同,用户会默认为文本也相同,进而认为内容同质化。

若相同图片出现次数较少,则可通过算法打散分发,不让同一个用户在短时间内看到相同图片内容即可。但若相同图片出现次数较大,则较难由分发打散,且部分分发场景是 timeline,算法不参与分发。

使用的识别形式包括两种,一种是计算图片 md5,使用绝对相等,一种是相似图模型识别。识别之后再结合一些策略,当相似度达到一定值,且相似或重复次数达到一定量,且由≥一定 uid 数量发布时,则会对之后进行发布的内容进行一些处理。

在这条通用策略之下,还会配置一些特殊策略,例如针对某些场景 / uid / md5 执行不同策略等。

2)重复文本

针对重复文本是和用户不断对抗的过程。

① 用户发布重复内容,平台开发重复模型,且将重复度≥一定值的内容判定为重复内容。注:治理重复内容本质是希望当前线上不给用户展示重复内容,所以对比内容库仅为线上内容。

② 用户对抗,用户将之前发布的内容删除后重新发布,平台将对比内容库增加已删除内容。

③ 用户对抗,用户通过删除一头一尾、替换部分文本、替换数字、更换不影响语义的标点符号 / 无意义字符、删掉部分内容、替换同义词、固定模板等方式,生产人工能快速判断为重复,但重复模型无法识别的内容。平台迭代重复模型,通过梳理用户改写的类型,迭代模型,使模型能够识别出这些类型的重复内容。

④ 用户对抗,用户通过随意摘抄一段菜谱、名人语录、歌词、电影台词等,平台通过制定审核规则,由人工判断。

⑤ 用户通过其他无法预知的方式生产重复内容,平台通过产品功能优化来解决。例如:

- 要生产重复内容,则会从一个地方复制然后在另一个地方粘贴,则可在粘贴提示、粘贴限制等产品功能上优化;

- 生产重复内容的用户有个共性,发帖量较大,则可对单位时间发帖上限做限制;

- 有粘贴行为的用户较大概率为重复内容生产者,则可通过粘贴行为拎出用户做离线数据分析,从用户维度进行处理;

- 也可对新进行用户教育、新手引导、优质内容引导等。

注:以上仅为极简的策略,在实际应用场景上还有很多细节限制,例如重复文本的判断仅针对字数≥一定值的内容才执行;例如评论场景和帖子场景会差异化的配置;例如重复模型迭代需要不断发现并梳理重复违规类型。

2. 虚假信息

对于任何平台都会存在虚假信息,这些虚假信息来自用户主动或不自知的生产。虚假信息虽然占比较低,但对用户的影响很大。可能是影响用户判断、可能是了解到错误信息、可能是进入到一个错误行业、可能是被骗钱财等,几乎每一个都会对用户造成较大负面影响。

不管平台是希望用户能够更相信平台,还是从平台承担着一定社会责任角度来说,都需要治理虚假信息。

要治理虚假信息,第一个问题一定会问:什么是虚假信息?

并不能说让模型判断,模型觉得是虚假的就是虚假。也不能让审核人员自己判断,他觉得是虚假就是虚假,那可能会出现审核人员 A 觉得是虚假信息,但审核人员 B 觉得不是虚假信息。

但也没办法给虚假信息一个统一的定义,如果能给出,那一定是去掉了很多细节,是不具有可执行性的一个定义。

所以只能看大量 case、以及看用户反馈、用户举报信息、审核反馈等,收集大量可能是虚假的信息。再自己判断其中属于虚假的信息,再划分不同场景,根据每一个场景制定不同的标准,定义清楚什么叫做虚假信息。

举例我们制定过的几个细分场景下的虚假信息的定义。

① 外卖员、快递员等,晒收入截图,月收入超过一定值,或日收入超过一定值,则定义为虚假信息。从行业数据来看,能达到这个数值的用户不到 0.5%, 相对虚假信息带来的危害,平台宁愿接受这部分误伤的存在。

② 男性,发布女性照片, 并且表达意思为想相亲,如果有大哥觉得合适可联系我,则定义为虚假信息。可结合用户认证信息、机器识别照片及文本语义来判断。

③ 用户在一定周期内过渡频繁的在内容中更换职业,例如昨天的发帖说自己是理发师,今天说自己是电焊工,明天说自己是厨师,则判断为虚假信息。因为正常用户不会在这么短的周期内这么频繁的更换职业,在我们内部称这类型用户为“百变小樱”。

此类用户目的大多为吸引用户联系自己,以便进行下一步诈骗。我们也会制定相应的策略来识别,在一定周期内用户发帖的身份大于等于一定值,则会送人审,结合这个用户的其他信息来判断是否属于百变小樱(因为这个策略存在相对较高的误伤,所以不能机器识别后直接处理)。

通过对虚假信息定义的经验,可形成以下四个步骤来定义治理问题的标准化流程。

- 步骤一:通过各种渠道浏览大量样本,渠道包括自己浏览、用户反馈、用户举报、审核反馈等。

- 步骤二:针对样本做特征分析。

- 步骤三:总结归纳。

- 步骤四:细分场景制定标准。

3. 话题不相关

话题不相关是指,内容行业为了控制生产方向,往往会产生话题,让用户基于话题进行生产相关内容。

但用户在生产内容时,可能由于生产成本过高,或无能力生产相关话题的内容,或其他原因,会主动去生产和话题不相关的内容。

对于用户消费聚合内容来说,这就属于垃圾内容,例如在一个聊 AIGC 的话题下包含一篇聊母猪的产后护理的优质文章,对于用户来说是不需要的,在这个场景下属于垃圾内容。

对于识别和话题不相关的内容,开发了话题相关度模型,根据相关度高低来决定给创作者多少奖励,及决定内容应用场景。

模型主要识别两个方面。

一类是与话题不相关,例如将话题复制一遍、内容和话题完全不相关、答非所问、内容完全无意义、同一领域但完全没回答问题等。举例:

- 话题:快递派送前如何录入系统?

- 内容:快递派送前如何录入系统?他们都在一各家一各减的少吗?少马国系统所以说相对来说还是比较麻烦的,只不过是少马路系统,这样的话基本上不会有酒驾的问题,我觉得还算是很不错的吧

另一类虽然与话题相关,但脱离话题的限定条件,例如话题限定了行业、需包含收入水平、限定了场景,但内容并不包含相关信息。举例:

- 话题:因为做焊工工作,你得了什么职业病?

- 内容:没从事过焊工,不过倒是有职业病,比如筋膜炎等。

4. 水帖

来自百科的定义,水帖:水帖是贴吧、论坛或bbs中一种对于主题不重要的、无意义的帖子的统称。

对于社区来说, 内容中充斥着水帖,会降低整个社区内容质量,成熟社区都会治理水帖。

在具体治理过程中就需要生态治理产品去发现水帖并总结归纳类型、思考是否需要治理、治理到什么程度、以什么工具治理、给予什么处罚等。

下面举例一些制定过的策略、规则,以及使用过的识别模型。

① 纯文本,且字数小于等于一定值

通过分析历史数据发现,当用户发帖小于等于一定值,且不带图片时,对于我们平台,这条内容基本不具有消费价值,就会以一种用户无感知的不分发的形式处理。

举例:啦啦啦、夕阳无限好、美好的一天、湖州你好

② 仅包含标点符号、数字、emoji 等

③ 部分 uid 在部分场景发帖 / 评论

用户每次违规都会有记录,也会扣相应的分数,当某些类型的违规在一定周期内达到一定次数,或一定周期内的扣分数达到一定值,则会对用户进行处罚,即阶梯处罚。

举例,用户在 7 天内发布水帖次数≥10 次,则会将用户在激励场景的发帖或评论全部不给予奖励(注,这并非系统完整逻辑,也并非真实数字)。

④ 命中水帖治理词库

⑤ 多账号多设备

若用户同一个设备上一定周期内登录过多个 uid,或一个 uid 在多个设备上登录过,分析这些用户的历史数据,发现较大量的存在无法识别的水帖(因为平台策略是有限的,用户违规方法是无限的,当用户了解平台策略之后,会用各种办法逃过策略)。

所以会制定一条策略,当用户触发「多账号多设备」时,则会将他内容送入更严的模型,例如普通用户对于低质模型,达到 0.9 才处罚,对于「多账号多设备」用户的内容,则达到 0.8 就会处罚。

⑥ 文本中包含某些关键词,且文本字数≤一定值

在评论场景,当把所有水帖内容拉出来看时会发现,水帖内容也会有一些共性,例如字数相对较短,虽然长尾很分散,但也会有一些头部的高频词汇,例如红红火火恍恍惚惚、哈哈哈、支持一下、谢谢分享、开心每一天、打个卡、你好、谢谢、加油等内容。

对于一些短文本,这些词为主要内容,则可理解为水帖。如果是一段 100 字评论,里面包含这些词,则不能认为这是水帖内容。如果不限制字数或比例,则会很容易出现误伤。

但这对不同平台的处理严格程度不同,我们平台会选择治理,其他平台可能会选择不治理。治理是因为宁愿用户少看到评论,也不愿让用户看到低质评论,以及避免带来连锁反应,其他用户跟着学。

⑦ 非新年期间评论包含「新年快乐」

这是在我刚开始做风控时做过的一条非常失败的策略。

背景信息,分析历史数据发现,五月份有部分用户在评论区大量发布「新年快乐」相关评论,虽在设备、IP、账号、注册信息、登录信息等均无关联性,但从发布的内容及发布内容时间来看,基本可确认是属于同一个人或团伙在操作。

且发类似文本的账号在不断新增,所以没从账号或设备维度进行治理,而是仅从内容维度出了策略,策略逻辑:在非新年期间评论新年快乐及其变形的文本做自见处理(仅自己可见)。

这条策略失败的点在于,只能解决了当前存在的这个特定问题,未考虑这类问题在将来如何有一个通用的解决方案。例如用户将「新年快乐」变为「中秋快乐」或「背包好看」就失效了,且用户的变形成本极低。

例如可以计算单个用户周期内词频,一定频率可直接处理,一定频率可送人审。也可以计算全局周期内词频,对于环比变化过大的词可给人工预警提示等。

⑧ 低质模型

低质模型识别包含语句通顺度、虚词、感叹词、乱打字、文本无实际意义等逻辑,以及一些既定策略会融合进模型。

虽然很多策略可融合进模型,但由于策略的可解释性强,易调整等优点,还是会让一些策略单独存在,不融合进模型。

以上一些案例几乎都是从内容维度来识别,进而从内容维度进行治理,但在工作中还有较大一部分是从内容维度识别,然后从用户维度进行治理,以及从用户维度识别,从用户维度治理,从用户维度进行治理将在下一章展开说。

以上所举例都是发现了某些问题,然后进行治理,但如何去发现这些问题的,在这篇文章中有详细说:《风控:上线一条规则/策略的完整流程》。

5. 联系方式

所说联系方式包括图片 / 视频 / 音频 / 文本中包含手机号、微信号、qq、网址、二维码等联系方式,以及以上内容的变形。例如空格隔开、中英文、拼音、手写、中文音异、电话通话截图、半打马赛克、形异、文本头像结合、拍摄名片 / 拍摄二维码 / 海报 / 宣传单 / 纸条 / 手写联系方式、手写并简单计算,以及诱导联系方式等。

我们不允许发布联系方式,因为社区场景不需要联系方式。并且经分析历史数据发现,当出现联系方式时,比较大概率会同时出现诈骗、刷钻引流、广告、逃单、隐私安全、线下风险、骚扰、账号交易等,带来危害比较严重,且容易漏识别,所以可从杜绝联系方式角度降低诈骗、刷钻引流、广告等问题。

针对这些问题也会建设对应策略来识别。举例部分策略:

- 文本中数字或字母连续≥一定值,则认为这是连续方式;

- 检测电话、QQ号、微信号、网址、二维码;

- 检测数字+分段联系方式;

- 检测变形联系方式;

- 检测多昵称拼接联系方式;

- 检测多条回复拼接联系方式;

- 检测含数字变形的联系方式;

- 检测内容包含恶意引流文本且检测包含联系方式;

- 以及制定人工审核规则等;

- ……

一些案例:

- 点击[http:/xxxxxxxx]查看表情

- 看到你的留言了,佳沃k16rvvf7

- 为我,A嗯6嗯0嗯5嗯9嗯3嗯9嗯8嗯

- 妖雾气 呜呜妖吧 妖雾三气

- 加v ➕yan 七二四三九xx五

- 想了解咨询我吧:壹肆柒xx伍零柒柒柒捌!!!!

- l六七4420五xx久

- 请连起来152号823室791厅66聊

- 1️⃣7️⃣6️⃣9️⃣3️⃣1️⃣9️⃣8️⃣8️⃣3️⃣

- 📞一三八0⃣️一四七0⃣️二八三

- 栾城房源出租,三室精装拎包入住。看房电话180-3xx1-3401苏星

- 招美团骑手,微信电话同步188..4381…2xx6

- 中山市 上门回收 空调 冰箱 洗衣机 纸皮等 上门回收范围 中山市 小榄 东凤 东升 古镇 横栏 需要回收旧电器和废品 的朋友们可以私聊本人宝师傅 ①③⑥②O③⑧②②⑨

- 各种广告牌,安装,设计,制造,电话199。0161。xx27

- 本人有一辆电动车三轮车转让,有需要做各种小吃可以联系我178♥44xx♥0758谢谢

- 让每个家庭拥有一个懂健康的人,管理家人健康,远离各种疾病。一起学习交流健康知识。18三,1 五七,6 4四二

- 昌黎上风上水六加一电梯洋房二楼106平带大下房,电话一,八。 三 !三五,(七;八。九/(五@ 9同微信,有意者联系我

- 乔家沟租个房子 最好是独院 让养猫 养狗 有的➕176…~3616……xx19

- 花都北门轻纺城自己的房子出租,一室一厅一厨一卫,需要的联系,微信同号1八七六九零零三xx三

6. 广告

绝大多数平台都不允许,或者至少是不希望平台内充满用户发布的广告,只是不同平台的处理方式不一样。朋友圈可能是折叠,小红书可能是不给流量,其他平台可能是无法审核通过。这些广告由于大量重复、低质、以及无法验证真假、影响公司其他业务、污染信息流等问题,平台通常会选择治理广告。

对广告的治理和虚假信息的治理类似,没办法对「广告」有一个统一的定义,所以得梳理 case,在各个细分场景制定规则。

- 举例一些制定过的策略;

- 对广告文本的检测;

- 对出租求租信息检测、对招聘求职信息检测;

- 对屏蔽词库检测、对刷钻吸粉词库检测、广告法词库检测;

- “连、起、来”开头结尾黑产检测;

- 过引流模型;

- 营销反作弊数据检测;

- 以及制定相关的人审规则;

- ……

上面举例的是一些识别广告的策略,但从广告特性上来说,用户发布广告绝大部分是希望能够与自己联系,所以具体在治理时大部分是从联系方式、私聊角度来治理,会更高效。或者根据多条策略的结果结合来决定处罚方式。

以下两个案例为引流模型识别出来的内容。

- 带一些新人,看个人银行额度赚钱,一天一万+ 感兴趣私聊详谈。

- 押车借款利息低,额度高。

注:还有很多类型内容也属于广告,但会被划分到更细的分类里面,例如「副业」类、「医美」类。

7. 不文明用语

对于不文明用语,在不同平台的接受程度不同,我们平台会治理辱骂及不文明用语,希望给生产者及消费者带来一个更文明和谐的生态环境。

治理方式主要是辱骂词检测、辱骂模型检测,以及人工审核。对于词库网上可找到公开词库,以及平台自己不断完善。对于辱骂模型,属于中台工具,业务只是应用,模型具体逻辑未有机会详细了解。对于人工审核规则,则会结合上下文本判断。

8. 其他类

有很多细分分类被治理过,除了前面展开说的七种,还包括这些。

- 街拍视频、网红无意义摆拍等无消费价值的视频,对其他平台可能属于优质内容,但对我们业务定位来说,则不需要这类型内容;

- 低俗类、软色情类;

- 重复领养、赠送、配对;

- 视频带水印,因为希望用户发布原创视频,而不是从抖快等平台盗视频来发布;

- 个人隐私,例如涉及完整的各类证件号、爆料某人,并且涉及家庭住址电话号码等隐私信息;

- 诈骗类,这其实也是一个大类,下面还可以划分很多细分场景进行治理,例如信用卡类诈骗、创业合伙类诈骗、相亲类诈骗、理财类诈骗、东南亚招聘类诈骗、菠菜类诈骗;

- ……

9. 治理中一些常用工具(模型能力)

重复模型、相似图模型、低质模型、网赚模型、涉黄模型、低俗模型、引流模型、辱骂模型、涉政算法等。

识别香烟、变形联系方式、政治人物、明星、美女图、emoji、血腥、暴恐、蜡烛、刀具、识别人体各个部位,包括腿 / 胸 / 肩 / 背 / 臀等。

业务进行治理时,大多数能力会应用中台能力,部分时候由于中台无法提供个性化能力或时间紧张等原因,业务会自己开发模型。

三、从用户角度做治理

我的工作是内容治理,但很多情况下内容不易识别,会考虑从用户角度来做内容治理,从作弊动机出发。

对于我们业务,用户作弊动机主要分为两类,一类是发广告,一类是通过做任务进而获得收益。

对于发广告动机的用户,从内容角度特性明显,例如高频发布重复内容、都带联系方式、主要从非赚钱入口发布等,比较好治理,涉及到用户相关只有用户在短期内多次发布广告,然后拉黑用户。

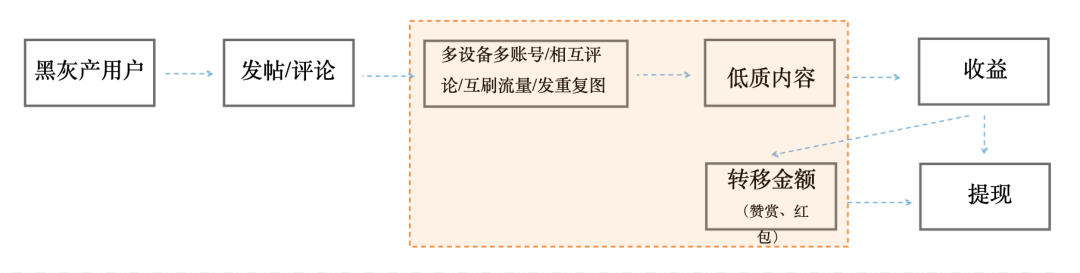

对于通过做任务获得收益,用户会有一个完整的作弊流程,如下图:

- 正常用户的流程:注册 → 登录 → 发帖/评论 → 获得收益 → 提现。

- 作弊用户的流程:注册 → 登录 → 发帖/评论 → 多设备多账号/相互评论/互刷流量/发重复图等 → 低质内容 → 获得收益 → 转移金额 → 提现。

作弊用户的流程中每一个环节均有多种可作弊空间,例如:

① 注册 / 登录,可能会涉及

恶意注册、批量注册、设备指纹黑名单、黑卡账号、机器登录、猫池、root、hook、篡改设备、安装黑产工具 & 模拟点击 App、篡改 ua、安装改机app、安装云控 App、短时关联用户过多、参数格式错误、参数间不匹配、设备硬件信息不匹配等。

注:这些信息均为网络公开可了解到的信息,不涉及公司机密,不代表我们公司全都用了这些,也并不代表我们公司只用了这些信息。

② 发帖 / 评论,可能会涉及

发帖后删除、短时间互动量超过一定值、以各种方式生产平台不易识别的违规内容、同一个人拥有多个账号多个设备发帖、使用相同图片等。

③ 获得收益,可能会涉及

仅从在某些激励场景发帖、仅给某些用户互动、互动量主要来自某些用户、互动量主要来自某些渠道、浏览及被浏览数据异常,包括渠道 / 时间 / 用户 / 用户等级异常等问题。

④ 转移金额,可能会涉及

因为平台限制提现必须绑定微信,所以用户会将多个账号获得的金额转移到一个账号上,然后进行提现。

转移金额异常,包括单次转移金额、累计转移金额、转移金额对象、金额来源占比等的异常。

上面提到的某些行为可能会贯穿用户生命周期全流程,例如机器模拟点击,所以在接入策略时也需要在各个需要验证的场景均接入。

由上面可知,黑灰产可能会在各个环节作弊,一个完整的风控方案也应该是全流程各个环节进行防控。

举例可参考的策略:

- 用户有机器注册、篡改设备、模拟点击等行为时打上一个标签,但并不直接处理,会在用户后续有其他行为时在结合这些标签决定是否需要处理;

- 对获得奖励后删帖的用户拉入一定周期的奖励黑名单,例如用户获得奖励后,将内容删掉,则此用户在接下来几天不可获得奖励;

- 触发违规做任务用户,限制做任务;

- 设置发帖上限,在一定周期内仅可发一定量的帖,超过则提示暂时不能再发布;

- 针对多账号、多设备以更严的策略识别其内容;

- 识别为互评、刷流量不给予奖励;

- 降低金额转移上限,用户作弊会有作弊成本,降低转移上限可提升用户作弊成本,保持收益 ≤ 作弊成本,用户会主动放弃作弊。注:这个上限设置也需要控制对正常用户的误伤;

- 分析金额转移数据,针对收入来源异常、收入总金额异常、收入与等级不匹配等用户,再结合其内容及触发机器模拟操作 / 改机等相关标签离线处置用户。

四、处罚方式

在治理中,对内容、对人,都会有很多处理方式,例如常见的通过、拉黑、删除等。

1. 对内容

对内容处理方式相对较简单,例如,包括通过、不通过、自见(仅自己可见)、沉贴(去个人主页能看见,但不分发)、降权分发、仅在部分场景分发、加精选、置顶等都可用理解为对内容的处理方式。

2. 对用户

对用户的要相对复杂些,但常见的可以按照以下这样来划分。

1)标记

仅做标记,不直接处罚,例如机器登录,在登录时判断为机器登录,会依然让用户进行后续动作,可结合后续动作再决定是否处置。这样好处是避免误伤、环节更长黑灰产也更难摸清平台的策略,以便减少变形对抗。

2)挑战

策略、模型都有一定误伤,为了降低对误伤用户的伤害,对触发某些策略,则可让用户输入验证码、滑块等方式做挑战,挑战成功则可以继续使用,挑战失败,则继续限制。

3)处罚

阶梯处罚,每次内容违规会对用户扣分,在一定周期内分数达到一定值时,会出现相应功能限制。举例,用户在评论区发一条辱骂文本,则可以扣 1 分,但不处罚用户,如果在 3 天内发了 10 条,扣了 10 分,就可限制用户 3 天不允许评论。

黑白灰名单,最简单的理解就是将用户拉黑,但是从限制主体、限制功能、限制时间上会有很多组合。

主体,可以是账号、手机号、设备、身份证、银行卡、微信等。

时间,可以是 24h、3 天、1 个月、1 年、永久等。

功能,可以是限制登录、注册、绑定、发布、点赞、查看、精选等。

组合起来举一个例子就是,限制某个账号在 3 天内不能登录,这就可理解为被拉入黑名单了。

注:黑白灰名单的组合如果做到足够细致,几乎可以有无限种组合,但需在满足业务需求,和易用性之前做好平衡。据说淘宝有数百种处罚方式。

柔性触发,即让用户做挑战。

用户教育,对于屡教不改的用户,平台可能会拉入黑名单,但由于用户在无知的情况下第一次犯错,则可让用户做一些答题、学习规范等。举例,哈罗单车在第一次违规停放,可在通过答题学习规范后取消处罚,第二次再违规停放,则会扣 20 块钱。

随机处罚,这是为了解决一个问题,平台上线一套策略,用户比很快就能试出了策略逻辑,所以会将相同违规的用户选择性放过一定比例,给予不同的处罚,甚至不处罚,让用户更难摸清平台的策略逻辑。注:需考虑哪些策略使用随机处罚,选择哪部分用户放过。

迷城,是为了在用户无感知的情况下,避免用户带来的伤害。一些在已经判断为违规的用户,并未限制其使用私聊功能。因为如果限制,则用户容易变着方来违规,增加平台对抗成本。例如可将用户发的消息转接给平台机器人(或固定回复策略),让违规用户和机器人私聊,这样可避免其他用户收到这个用户的违规消息。

五、治理经验

- 做风控需要非常了解业务。

- 尽早建立指标评估体系,在工作推进将会大大降低阻力。

- 任何时候都得有兜底方案。

- 黑灰产作弊一定有作弊动机,有作弊成本,可多从提升作弊成本打击作弊动机角度考虑。

- 木桶原理,风控水平取决于防御体系最薄弱的环节,漏洞被利用的速度远超你的想象。

- 训练数周的模型比不过一条业务规则,这是常有的事情。

- 对于黑灰产治理,需要系统性的主动防御,避免被黑灰产牵着鼻子走,永远有堵不完的口子,填不完的坑。

这里核心是两个词主动、系统性。

主动,需要对业务足够熟悉、对黑灰产产业链足够了解、有情报来源、掌控黑灰产动向,在还未发生某些风险之前就提前堵上漏洞。

系统性,需要全链路防御,技术结合产品功能、运营一起形成系统性防御。包括在产品的各个可能出现问题的场景上的事前、事中、事后的防御。以及相应的监控体系、预警体系。

用户为了达到作弊目的,他在业务的每一个节点都可能出现异常,所以在治理前首先要绘制出完整的用户行为路径,理清楚每一个可能产生异常行为的业务位置,然后从各个节点全链路的打击,可参考上面「从用户角度做内容治理」这部分。注:不要指望在一个业务节点上解决所有问题。

每个业务节点的数据串联是重中之重,当前业务节点产生的所有有效结论,都应该流入下一个业务节点作为辅助特征。下游节点产生的确切结论,也应反哺上游判断。

找到绝对原因很难,但这不影响工作推进。有时候很难找到一群账号是否有血缘关系,但从他们的业务数据上来看,基本可确定这是一群人,则可先处理。

六、最后

这篇文章是在写实际治理的问题,以及应用的方法,接下来会更新一篇治理的整体框架,即把本篇抽象归纳出一个通用框架。

本文由 @Aaron 原创发布于知识吧。未经许可,禁止转载

题图来自Unsplash,基于CC0协议